10 tendências principais de BI e dados para 2023

Preparação para a crise

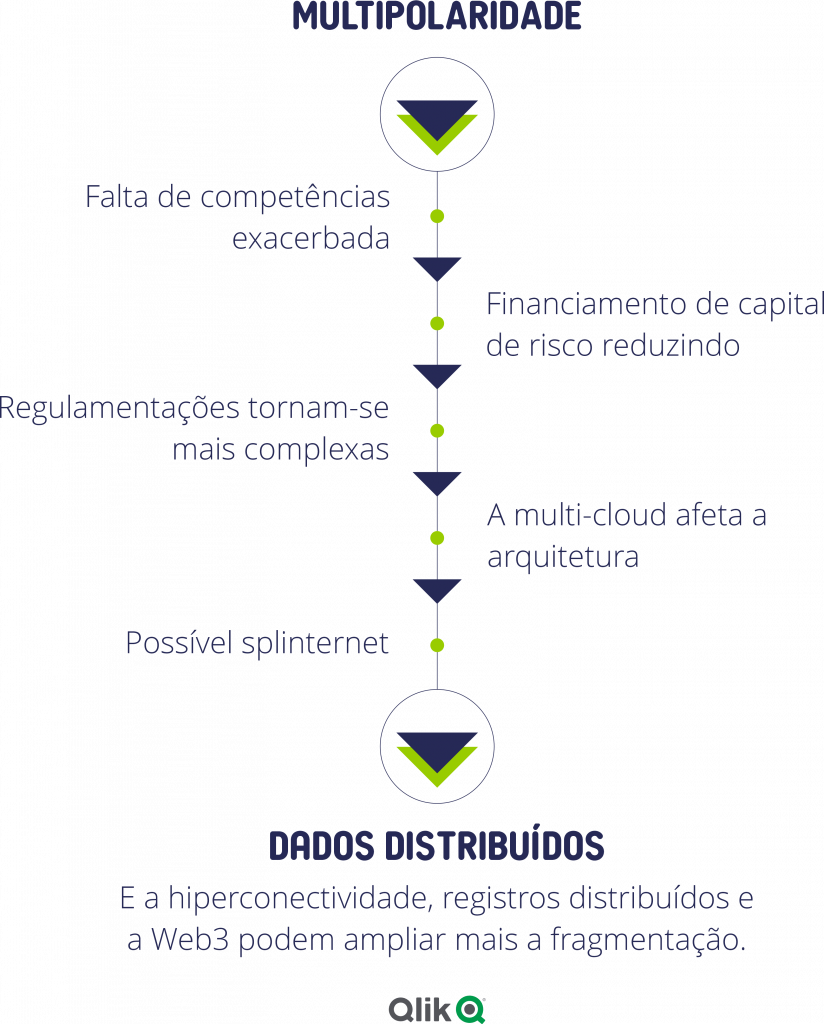

Poder e dados estão mudando. Ambos estão ficando mais fragmentados.

Nesse momento na história, estamos em uma tempestade perfeita. Preocupações geopolíticas, sociais e econômicas nos agitam. Vemos um aumento em tendências de conflito e isolacionismo, em vez de um movimento pela cooperação, as regulamentações locais estão se ampliando. Na economia, a confiança é baixa, o medo da recessão é alto e os juros aumentando – além da inflação – afetam os empréstimos. O que esses fatores têm em comum? Muitos estudiosos defendem que estamos em meio a uma mudança para a desglobalização.

E assim veremos novas fraturas em antigas estruturas e o surgimento de um estado de multipolaridade ou a distribuição de poder entre diversas entidades. Enquanto o atropelo acontece em nível internacional,

sentimos os impactos localmente, em nossa vida pessoal e profissional. Entre outras repercussões, seremos desafiados por cortes de energia, flutuações do câmbio, cadeias de suprimento interrompidas e mercados buscando sobreviver. A multipolaridade também afetará significativamente a tecnologia da informação.

Como profissionais de dados e analytics, temos de nos adaptar a mais fragmentação, com data centers dispersos, cadeias de suprimento interrompidas, inovação constante e dificuldade de acesso a mão de obra experiente.

E em um mundo em que a crise tornou-se constante, preparar-se para ela torna-se uma competência essencial – para podermos reagir no momento e prever o que pode acontecer.

Os dados não estão mais presentes

Conforme o Gartner, até 2025, mais de 50% dos dados essenciais para as empresas serão criados e processados fora do data center ou nuvem. – Gartner

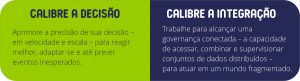

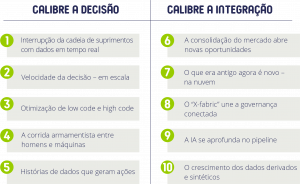

É hora de preparar-se para a crise.

E isso requer duas competências essenciais.

Durante a pandemia as organizações adquiriram novas tecnologias simplesmente para continuar operando. Nessa repentina modernização, sistemas e processos tornaram-se uma emaranhado caótico. Agora é hora de atuar com firmeza em áreas como governança, capacidade de resposta e custos da nuvem.

Nesses tempos desafiadores, quase 70% dos líderes globais de tecnologia preocupam-se com o crescente investimento em tecnologia necessário para permanecerem competitivos.

Mas poucos, ou nenhum, buscam reduzir seus esforços com dados. Em vez disso as pesquisas indicam³ que a integração de dados, analytics, automação, gestão de API e IA são as principais tecnologias nas quais os CXOs confiam para a gestão de crises. E agora é hora de utilizá-las. No próximo ano e além, acreditamos que será importante concentrar-se em duas áreas em particular:

10 principais tendências de BI e dados para 2023

Calibre a decisão

1. Interrupção da cadeia de suprimentos com dados em tempo real

Quem tentou comprar um novo carro (ou computador ou materiais de construção) nos últimos anos conhece o alto grau de comprometimento das cadeias de suprimento.

As interrupções podem ocorrer em qualquer parte do mundo e exigem uma reação imediata.

Isso significa agir com planos de contingência e até, se possível, “antecipar” – em outras palavras, usar previsões e cenários para mudar antes que as coisas comecem a piorar. A infraestrutura para operar com dados em tempo real já existe há algum tempo, mas os casos de uso críticos e todo o seu potencial ainda não foram plenamente explorados. Mas agora devem ser. Enfrentamos a gestão de estoques quando as matérias-primas são escassas e os envios são interrompidos, sendo necessário identificar os gargalos na cadeia de suprimentos para reabastecer e trabalhar com mais eficiência com os parceiros. E temos de desviar recursos para enfrentar novas oportunidades ou atender necessidades humanitárias quando surgem conflitos. E o ritmo desses problemas vai acelerar.

O impacto

A pandemia e o conflito na Ucrânia criaram uma escassez significativa de componentes. Essa situação fez as organizações atualizarem seus pipelines de entrega de dados, de orientados a lote para dados quase em tempo real. E enquanto mais dispositivos na ponta surgem na grade – produzindo fluxos contínuos de alto volume de dados – surgirão mais oportunidades de aproveitar os dados em tempo real.

Previsão do analista

Em 2027, 60% dos gastos em tecnologia de captura e movimentação de dados estarão em agilizar pipelines de dados, permitindo uma nova geração de recursos de simulação, otimização e recomendação em tempo real. – IDC

2. Velocidade da decisão – em escala

Uma vez que você tenha dados em tempo real, a próxima etapa é ajustar suas decisões operacionais no mesmo ritmo. Por exemplo, em tempos de inflação um varejista não pode repassar todos os seus aumentos de custos aos clientes. Em vez disso ele deve aumentar as eficiências – milhares delas, milhares de vezes por dia.

A automação ajudará. Conforme o Gartner, 95% das decisões baseadas em dados serão ao menos parcialmente automatizadas e, em um ambiente mais desafiador, a automação acelerará. Mas embora analytics, IA e automação possam tomar mais decisões e mais rápido do que as pessoas, certifique-se de colocar as pessoas no início e no final dos ciclos de automação de decisão para projeto e revisão.

A velocidade da decisão em escala também trata de reduzir o pipeline de dados até a ação para as pessoas – reduzindo o tempo para as pessoas encontrarem dados e aumentando a frequência da ação a partir deles. Além da tecnologia, a alfabetização de dados é um facilitador essencial para isso. E finalmente, a velocidade da decisão deixa um rastro de big data, com padrões analisáveis. Isso criará uma abertura para a mineração de decisões.

O impacto

Novas funções surgirão com foco na inovação de decisões – como Chief Decision Officer, Decision Designer e Decision Engineer. Essas funções trabalharão não só com a automação de decisões de rotina mas também enfrentando os seus maiores e mais complexos problemas.

3. Otimização de low code e high code

Nos últimos anos vimos surgir ferramentas low-code para criar aplicativos, permitindo que o pessoal não técnico crie seus próprios apps.

Essas ferramentas não só criam apps, elas também aumentam o consumo de dados e insights. Por exemplo, a automação de aplicativos permite aos trabalhadores criarem cadeias de eventos acionados por dados. O AutoML dá aos analistas de negócios acesso aos algoritmos mais avançados. E as transformações de dados nos pipelines de entrega de dados também podem ser amplamente automatizadas.

Uma ferramenta proeminente é o GitHub Copilot (baseada no GPT-3), que converte frases em inglês para código.

A GitHub estima que o Copilot gera uns 30% do código de aplicativos criados no site. Por outro lado, algumas organizações têm programadores e desenvolvedores de app que só desejam comandos que possam programar. Isso ocorre principalmente em engenharia e ciência de dados, campos que foram reinventados

para a nuvem. Para atender a essas necessidades, vimos surgirem ferramentas high-code, com modelos para programadores que desejam a máxima flexibilidade.

O impacto

Esses dois campos sempre existirão, embora muitos casos de uso gradualmente evoluirão de high-code para low-code quando os fluxos de trabalho repetíveis forem identificados e os mercados amadurecerem. Mas a opção não será entre low code e high code. Em vez disso, deverá ser a otimização do código, voltada para a máxima produtividade e os melhores resultados de negócios em função dos conjuntos de competências disponíveis.

Previsão do analista

Até 2023, 60% dos novos apps serão desenvolvidos em plataformas de nocode/low-code, bem acima dos 30% atuais. — IDC

4. A corrida armamentista entre homens e máquinas

Em meados de 2022, um engenheiro do Google afirmou que um dos chatbots da empresa (chamado LaMBDA) havia alcançado consciência ou um nível humano de autoconsciência.

O Google afirmou que suas declarações eram infundadas – e o engenheiro foi demitido por violar as políticas de segurança da empresa – mas esse incidente mostra o quanto as máquinas evoluíram em pouco tempo.

Como modelos de linguagem natural foram treinados com imensos conjuntos de dados usando aprendizagem de máquina com uma profunda rede neural, elas alcançaram uma mudança de paradigma. Talvez a mais amplamente divulgada seja o GPT-3.

Ele tem tenta capacidade que fornece diversos serviços, de otimização de código a redação de textos de marketing, imitação do estilo de autores como Kafka e Hemingway.

Agora existem 5 ou 6 desenvolvimentos globais ainda maiores que o GPT-3, modelos treinados com conjuntos de dados ainda maiores. Só podemos imaginar onde isso irá nos levar. Podemos estar prestes a atravessar o Rubicão onde as máquinas finalmente passem no teste de Turing.

O impacto

No espaço de dados e analytics, recursos de linguagem natural terão imensas implicações em como buscamos informações e como ela é interpretada e relatada. Vamos encontrar não só os dados desejados mas também outros dados sobre os quais não pensamos em perguntar.

5. Histórias de dados que geram ações

Por décadas, nós do setor de dados compartilhamos um mantra: Forneça as informações certas para o usuário certo, na hora certa.

Isso agora é mais importante do que nunca. Mas em um mundo fragmentado, com dados distribuídos e tempo escasso, é uma tarefa difícil.

Felizmente, você não precisa enviar todos os dados a todas O impacto as pessoas todo o tempo. Ter os conjuntos certos de poucos dados na hora certa é mais útil. E nem todo insight precisa ser obtido com uma exploração do usuário. Muitos podem ser mais prescritivos e orientados para recomendação, entregues diretamente dos dados.

O storytelling de dados tem sido elogiado como a forma de enviar dados que fazem sentido aos usuários. As histórias podem despertar sentimentos nas pessoas e fazê-las agir quando os dados apenas não o conseguem. Mas o storytelling de dados necessita ir muito além de adicionar gráficos a infográficos ou PowerPoints. Ele precisa conectar-se com a ação.

O impacto

Para conectar o storytelling à ação, você precisa adicionar três etapas:

- Prever o que acontecerá a seguir e sugerir as melhores ações com o AutoML

- Usando alertas, relatórios e automação para levar as histórias aos fluxos de trabalho na hora certa

- Incorporar não só dashboards mas também micro-histórias nos sistemas em que as pessoas trabalham. Isso moverá o storytelling de dados dos insights que podem gerar suas ações para os insights sobre os quais você age.

Previsão do analista

Até 2025, as histórias de dados serão a forma mais presente de consumir analytics e 75% das histórias serão criadas automaticamente usando técnicas de análises aprimoradas. — Gartner

Calibre a integração

6. A consolidação do mercado abre novas oportunidades

Em um mundo cada vez mais fragmentado, existe também uma tendência de mercado no sentido oposto: a convergência.

Testemunhamos a consolidação de sistemas anteriormente isolados, incluindo integração de dados, gerenciamento, analytics/IA, visualização, ciência de dados e automação.

Combinar essas funções abre oportunidades antes impossíveis. Fica mais fácil para os produtores e consumidores de dados colaborarem, começando com o produto, resultados ou decisões que tenham em mente e fazendo engenharia reversa para criar pipelines de dados ágeis em função de suas metas de negócios.

APIs e padrões comuns permitem a interoperabilidade. E quando um fornecedor operar em mais segmentos, a convergência será ainda mais fácil. Não se trata de “tudo” em uma pilha de dados, o que pode levar a depender de um fornecedor ou comprometer a conformidade. Em vez disso, escolha plataformas que operem com múltiplas

pilhas e consolide os dados entre elas.

O impacto

O movimento para a consolidação no lado do suprimento encontra o lado da demanda. Em tempos desafiadores, CFOs e CEOs envolvem-se mais nos negócios e desejam ver o ROI claramente articulado. Isso ajudará a afastar os modelos de precificação de por usuário para o valor gerado. Afinal, você não consegue predeterminar quem na sua

organização deve usar qual ferramenta quando não sabe de onde surgirá o próximo desafio. E vez disso, facilite o acesso geral a ferramentas e plataformas, de forma controlada, e continue daí.

7. O que era antigo agora é novo – na nuvem

Durante a pandemia, as organizações modernizaram rapidamente os aplicativos e moveram dados para a nuvem.

Enquanto as mudanças amadurecem, muitas das mesmas questões do mundo on-premise estão aparecendo. Por exemplo, após adotar um warehouse ou lake na nuvem, você precisará lidar com a movimentação de dados, sua conversão, catálogos de metadados etc.

Essas necessidades estão gerando investimentos em diversos segmentos de software em warehouses e lakes – incluindo camadas semânticas e integração de dados, movimentação, fontes e observabilidade.

Isso criou um Velho Oeste de startups (que geralmente se denominavam parte da “moderna pilha de dados”) alimentadas por capital de risco, cada uma buscando uma especialização. E embora certamente surgirão vencedoras, a ampla maioria desaparecerá quando os setores amadurecerem e se consolidarem. E essa tendência acelerará quando o financiamento de risco desabar

(No T3 de 2022, o financiamento de capital de risco caiu 53%, sinalizando o que deverá ocorrer.)

Em outras palavras, espere uma grande onda de fusões e aquisições enquanto fornecedores de pequeno porte buscam uma saída. Isso aconteceu no mundo on-premise e acontecerá novamente na nuvem.

O impacto

De uma perspectiva de custos, não é sustentável as organizações trabalharem com uma ampla gama de fornecedores de nicho. Felizmente, muitos dos recursos serão recriados nas amplas plataformas integradas de dados e analytics. À medida que os mercados de nuvem amadurecem, os gerentes podem abandonar arquiteturas dependentes de diversas startups que lutam para sobreviver. Em vez disso, essas startups podem servir como fonte de “aquisição pelos talentos.”

Previsão do analista

Para ajudar a aliviar a falta de profissionais de desenvolvimento, 55% das organizações utilizarão marketplaces em nuvem e aquisições de startups de tecnologia como as abordagens mais importantes de fornecimento de software em 2024. — IDC

8. O “X fabric” une a governança conectada

A discussão em anos recentes foi sobre data fabric (além de hubs e mescla), uma metodologia importante que conecta conjuntos de dados distribuídos através de modelos semânticos. Mas para a governança conectada, precisamos de mais que isso.

Em um mundo com milhões de programadores, precisamos de outros fabrics ou “X fabrics.” Eles incluem application fabrics, BI fabrics e de algorithm fabric – e agora mesmo essas metodologias estão ainda menos maduras que o data fabric.

Ser capaz de reutilizar ativos de dados e analytics é essencial, abrangendo modelos, scripts e conteúdo de analytics. E a necessidade de reutilização também ressalta a importância do catálogo, além de seu crescente papel. APIs comuns possibilitarão ter modularidade e capacidade de composição e os catálogos fornecerão a supervisão que abrange artefatos.

O impacto

Para governança conectada você precisa de X fabrics. Você também precisa certificar artefatos com base em sua confiabilidade – por exemplo, com marcas d’água baseadas em limites. Cada organização hoje busca melhores maneiras de acessar seus dados e artefatos de analytics. E em um mundo distribuído, a orquestração torna-se ainda mais importante.

9. A IA se aprofunda no pipeline

Como mencionei na Tendência 6, analytics, automação e IA estão convergindo, cada vez mais se superpondo. No processo, acontece a polinização cruzada, gerando novos insights que antes não eram possíveis.

Mas e quanto a mover esses componentes mais profundamente no pipeline de dados, antes de criar um aplicativo ou dashboard? Isso pode beneficiar as organizações de diversas maneiras. Usar IA no gerenciamento de dados vai alterar a histórica distribuição 80/20 (entre preparar os dados e analisá-los) automatizando a maioria das tarefas de rotina na engenharia de dados.

Isso poderia, por exemplo, automatizar a detecção e geração de relatório de anomalias, aproveitando a autocorreção, usar a implementação just-intime e descobrir atributos de risco como dados de informações pessoais. Os algoritmos conseguirão “rastrear” os dados e desvendar insights além da sua hipótese. E finalmente, anotações e marcações automatizadas produzirão melhor engajamento com integradores menos experientes.

O impacto

Mais IA no pipeline de dados não implica a exclusão das pessoas. Afinal, as pessoas são excepcionalmente boas em sintetizar problemas complexos com múltiplos componentes. Mas a IA automatizará parte das tarefas mais tediosas de preparação de dados, para que engenheiros e cientistas de dados possam concentrar-se em tarefas mais

significativas.

Previsão do analista

Até 2024, as tarefas de integração manual de dados serão reduzidas em até 50% com a adoção de padrões de projeto de data fabric que suportam a integração de dados ampliada. — Gartner

10. O crescimento dos dados derivados e sintéticos

Dados são um ativo líquido, eles podem ter diferentes aparências para finalidades diferentes.

E hoje é mais fácil que nunca alterar dados para diferentes casos de uso ou convertê-los em formatos para metas específicas. Dados que foram convertidos, processados, agregados, correlacionados ou operados são chamados de dados “derivados”. Dados derivados têm sido particularmente úteis para gerenciamento de dados de teste – criando, gerenciando e fornecendo dados de teste para equipes de aplicativos.

Mas agora, com novas leis de privacidade e questões de integridade, torna-se essencial ocultar os dados ainda mais.

Em outras situações, dados úteis simplesmente não existem. A falta de dados de usuário disponíveis, por exemplo, pode ser problemática para pequenas empresas, incapazes de treinar seus modelos de IA com amplos conjuntos de dados. Ou uma empresa pode querer executar experimentos e análises de hipótese para casos – simulações de crime financeiro e fraude, por exemplo.

Nos dois cenários acima, dados sintéticos podem ser uma opção. Dados sintéticos são dados que não foram gerados em operações reais.

O impacto

Graças a diversos fatores – incluindo reutilização de dados, testes, leis de privacidade, dados ausentes e a necessidade de dados para treinar modelos de IA – veremos mais dados derivados e sintéticos.

O caminho a seguir

O que essas tendências significam para você?

Em um mundo fragmentado em que a crise é uma constante, é importante inovar e preparar-se. Comece pensando bem como sobre essas tendências se aplicam à sua organização.

- Identifique casos de uso em que a velocidade da decisão e dados em tempo real possam resolver os desafios

- Aproveite a combinação certa de otimização de código para seus usuários de negócio e engenheiros

- Veja como o storytelling de dados pode ser vinculado mais próximo à ação

- Use inovações em linguagem natural para levar a consulta de dados, insights e ações a mais pessoas

- Busque maneiras de convergir tecnologias isoladas

- Use fabric não só para seus dados mas também para outros artefatos

- Aplique IA no início do pipeline de dados

- Aproveite a crise de capital de risco para remediar a escassez urgente de pessoal qualificado

- Busque por abordagens de dados derivados e sintéticos para maximizar o valor em um mundo distribuído

Isso abrange mais do que apenas tecnologia.

Profissionais de dados de todos os tipos serão essenciais na preparação para a crise. Em um mundo em desglobalização, a disponibilidade localizada desses profissionais será cada vez mais importante. Para isso é essencial aumentar a alfabetização de dados de sua atual força de trabalho, com educação e tecnologia.

Fonte: Qlik

Fonte: Qlik

E-book completo do material: 10 tendências principais de BI e dados para 2023

E-book completo do material: 10 tendências principais de BI e dados para 2023